微软禁止员工使用ChatGPT:揭秘背后的安全与数据风险

更新时间:2023-11-14 07:20:42作者:xhjaty

微软禁止员工使用ChatGPT:揭秘背后的安全与数据风险

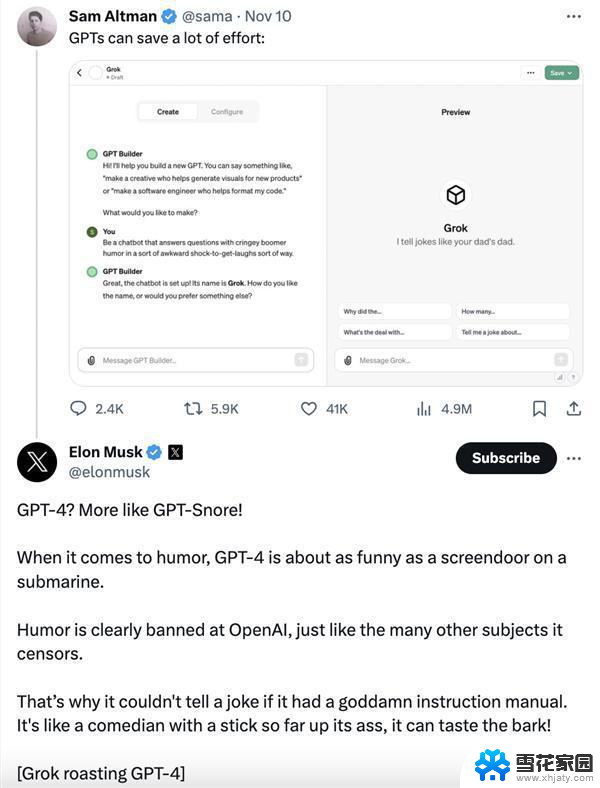

近日,微软公司下达了一项关于员工使用ChatGPT的禁令。引发了广泛关注。微软作为全球科技巨头,此举无疑给其他大公司提了个醒。重新审视员工使用ChatGPT等第三方外部服务的安全和数据风险。

ChatGPT是一款备受欢迎的聊天机器人,拥有超过1亿的用户。它的功能强大,能够进行自然语言对话、文本生成等任务,甚至在某些方面已经超越了人类。然而,这种技术的背后也隐藏着巨大的安全隐患。

微软禁止员工使用ChatGPT,主要是出于安全和数据方面的考虑。由于ChatGPT是第三方外部服务,存在隐私和安全风险。一旦数据泄露或被滥用,后果不堪设想。此外,员工在工作中使用ChatGPT可能会不自觉地分享公司的机密数据,给公司带来巨大的损失。除了微软以外,许多大公司也限制员工访问ChatGPT,通常是为了防止共享机密数据。这些公司深知,在日益严峻的网络环境下,保护企业数据安全刻不容缓。

然而,这并不意味着大公司们对ChatGPT等AI技术的态度发生了转变。相反,他们正在积极探索如何利用这些技术提高工作效率、创新业务模式。微软本身也在积极布局AI领域,推出了自己的聊天机器人工具——必应聊天工具。

微软的必应聊天工具不仅具备了ChatGPT的功能,还拥有更加严格的安全保障措施。通过采用先进的加密技术和严格的权限控制,必应聊天工具确保了数据的安全性和隐私保护。

微软禁止员工使用ChatGPT:揭秘背后的安全与数据风险相关教程

-

苹果与微软:成为最大空头标的的背后,揭秘背后的关键因素

苹果与微软:成为最大空头标的的背后,揭秘背后的关键因素2024-01-23

-

微软与苹果:市值之争背后的科技巨头角力,揭秘两家公司的竞争之道

微软与苹果:市值之争背后的科技巨头角力,揭秘两家公司的竞争之道2024-01-07

-

微软操作系统:霸道垄断与用户数据传输问题的解析

微软操作系统:霸道垄断与用户数据传输问题的解析2023-11-03

-

.NET8好用吗?微软:比.NET7超级快更快!——专业评测揭秘.NET8的超强性能

.NET8好用吗?微软:比.NET7超级快更快!——专业评测揭秘.NET8的超强性能2023-10-30

- 微软:中国用户必须将数据传输至美国才能使用Windows系统

- 微软发布Windows 10/11用户卸载OneDrive指南,终于可摆脱数据同步限制

- 微软证实:Win11/10的“65000”BitLocker错误已修复,系统安全再无后顾之忧

- 微软紧急撤回AI模型原因曝光,称其存在“有毒”风险

- 微软计划使用SignalR和其他开源工具构建AI驱动的Microsoft Copilot

- Windows 12来了!微软曝光体系细节:换血式升级,全面揭秘新一代Windows操作系统

- 国产操作系统们真到了可以围剿Windows的时刻了?国产操作系统发展势头强劲,是否能成为Windows的强大竞争对手?

- Windows7安装教程:详细步骤和图文指南,轻松学会安装Windows7

- 微软关闭多个工作室引发玩家抵制,斯宾塞下台!

- 前暴雪总裁Ybarra呼吁微软Xbox将重心转移到制作优秀游戏 上述标题涉及游戏产业内的权威人士及主题,相关度高。

- 华硕显卡维修费用高达3758美元,售后服务遭质疑

- 请问2020年win10最有用的杀软是什么?如何选择最佳杀软?

系统资讯推荐

- 1 国产操作系统们真到了可以围剿Windows的时刻了?国产操作系统发展势头强劲,是否能成为Windows的强大竞争对手?

- 2 微软关闭多个工作室引发玩家抵制,斯宾塞下台!

- 3 微软自研5000亿参数武器曝光,前谷歌DeepMind高管挑战OpenAI!

- 4 苹果或在今晚发布Apple Pencil Pro,雷军逛完北京车展后感到绝望

- 5 微软疯狂押注AI,焦虑和野心再也藏不住

- 6 次时代显卡的小秘密 这个选项你打开了吗?揭秘最新显卡的黑科技

- 7 Windows 11强制全屏弹窗?力推Edge等应用,用户体验受影响

- 8 下一代Windows要大变革:“真AI PC”要来了,革命性的人工智能电脑即将问世

- 9 NVIDIA ChatRTX聊天机器人支持Google Gemma模型和语音查询功能

- 10 如何修改电脑WIN10、WIN11系统excel、word底色?

win10系统推荐

系统教程推荐

- 1 电脑网络已连接不可上网是什么原因 电脑WIFI连接成功但无法上网

- 2 内存卡为什么不能格式化 内存卡无法完成格式化的原因分析

- 3 wps默认只读模式怎么取消 WPS文档只读模式取消步骤

- 4 怎么设置wpspdf默认打开方式 怎样让文件默认使用WPS打开

- 5 自己wifi密码忘记了怎么办 家里wifi密码忘了怎么办

- 6 耳机突然一只没有声音了怎么办 耳机一边没声音怎么办

- 7 笔记本处理器怎么换 笔记本CPU如何更换

- 8 怎么重置microsoft edge Microsoft Edge浏览器重置教程

- 9 台式电脑可以装蓝牙音箱吗? win10台式电脑蓝牙音箱连接教程

- 10 苹果手机个人热点电脑无法连接 苹果iPhone手机开热点连接不上电脑怎么办