微软发布自研芯片,英伟达黄仁勋为何站台?解析行业合作动机

更新时间:2023-11-16 20:22:15作者:xhjaty

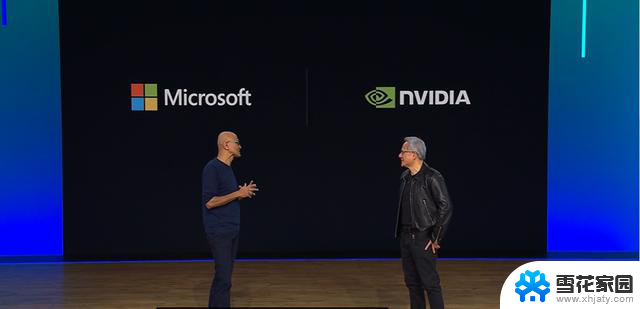

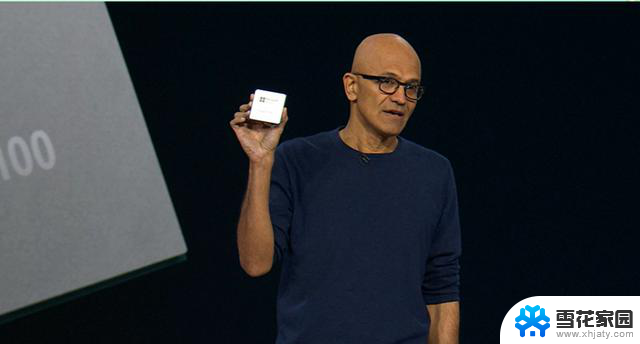

北京时间11月16日凌晨,“微软造芯”这颗飞了一个月的石头落地了:微软CEO萨提亚·纳德拉在Ignite2023开发者大会上发布两款芯片。一款CPU、一款AI加速器,均用于云服务,分别命名为Azure Cobalt 100和Azure Maia 100。芯片用于云服务,切中了网友的猜测。而此次发布会上还有两点超出了网友原本的预料:第一,没发布NPU,反而推出了一款CPU;第二,英伟达CEO黄仁勋被请到现场,大谈两公司在AI领域的合作成果,坊间猜测的“微软挑战英伟达”说在一定程度上被消解。果然,科技圈没有永远的市场争夺,只有慕强是唯一真理?微软为何要做CPU?“体量够大。”这是记者提问“为什么微软要做CPU时”,业界专家给出的答案。对于微软来说,云计算是当前最重要的业务板块、也是最大的盈利来源。在算力需求日益旺盛的当下,由购置处理器带来的成本已相当可观。自研处理器,很有可能是基于实现企业利益最大化的考量。芯谋研究企业服务部总监王笑龙在接受《中国电子报》记者采访时表示,靠自研芯片提升企业品牌价值可能是一些小企业的思路,对于微软这样体量的企业来说,自研芯片肯定是为优化企业业务服务。对于云计算厂商来说,传统的服务器通常由CPU和GPU两类处理器组成。其中CPU的主要供应商是英特尔和AMD,GPU的主要供应商是英伟达和AMD。而微软此次推出的两款芯片,恰恰对应这两大类型:Azure Cobalt 100是CPU,Azure Maia 100作为一款AI加速器,主要对应的是当前GPU的功能。萨提亚·纳德拉表示,这两款产品将先自用,再逐步对外供应。

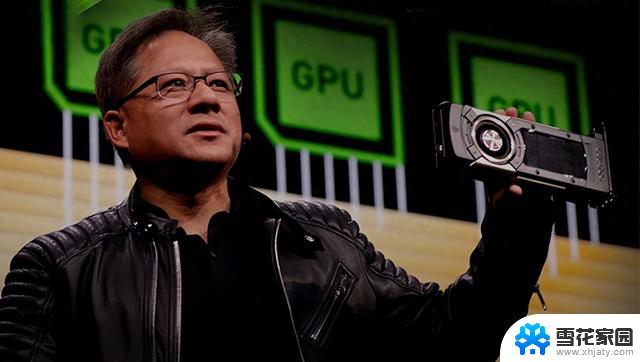

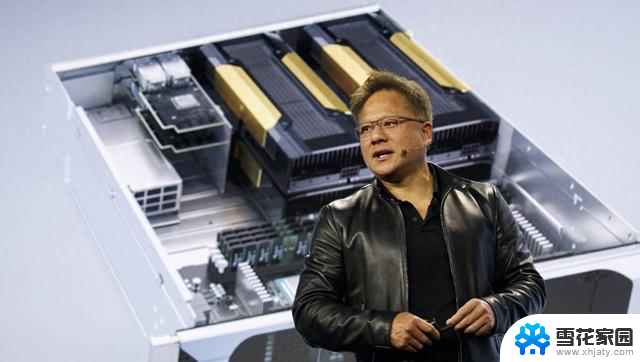

北京时间11月16日凌晨,“微软造芯”这颗飞了一个月的石头落地了:微软CEO萨提亚·纳德拉在Ignite2023开发者大会上发布两款芯片。一款CPU、一款AI加速器,均用于云服务,分别命名为Azure Cobalt 100和Azure Maia 100。芯片用于云服务,切中了网友的猜测。而此次发布会上还有两点超出了网友原本的预料:第一,没发布NPU,反而推出了一款CPU;第二,英伟达CEO黄仁勋被请到现场,大谈两公司在AI领域的合作成果,坊间猜测的“微软挑战英伟达”说在一定程度上被消解。果然,科技圈没有永远的市场争夺,只有慕强是唯一真理?微软为何要做CPU?“体量够大。”这是记者提问“为什么微软要做CPU时”,业界专家给出的答案。对于微软来说,云计算是当前最重要的业务板块、也是最大的盈利来源。在算力需求日益旺盛的当下,由购置处理器带来的成本已相当可观。自研处理器,很有可能是基于实现企业利益最大化的考量。芯谋研究企业服务部总监王笑龙在接受《中国电子报》记者采访时表示,靠自研芯片提升企业品牌价值可能是一些小企业的思路,对于微软这样体量的企业来说,自研芯片肯定是为优化企业业务服务。对于云计算厂商来说,传统的服务器通常由CPU和GPU两类处理器组成。其中CPU的主要供应商是英特尔和AMD,GPU的主要供应商是英伟达和AMD。而微软此次推出的两款芯片,恰恰对应这两大类型:Azure Cobalt 100是CPU,Azure Maia 100作为一款AI加速器,主要对应的是当前GPU的功能。萨提亚·纳德拉表示,这两款产品将先自用,再逐步对外供应。 萨提亚·纳德拉发布Azure Cobalt 100另一方面,现有处理器不是最适合AI的,几乎已经成为算力芯片供应商的共识。这也是在大模型浪潮的推动下,NPU、APU、TPU等AI专用处理器类型纷繁迭出的底层逻辑。在AMD、英特尔等传统处理器企业之外,芯片设计已经吸引了亚马逊、谷歌、腾讯、阿里等云服务商入场。作为服务器芯片最大的客户,以微软为代表的云服务商最了解对芯片的需求。从微软的角度来看,一面是可见的日益走高的处理器购置费用,另一面是选择更适配AI硬件的需求推动。拿出一些成本,给自身业务的硬件配置提供新选择,何乐而不为?而选择做CPU,而不仅仅是做AI加速卡,恐怕也是基于未来增长可能性的考量:在自己已有相当的市场容量的基础上,采用功耗更低的Arm设计CPU,也可以在一定程度上实现风险对冲。那么微软造芯,真得能做得好吗?所谓微软“造芯”,实际上是指入局芯片设计行业。从芯片的全生命周期来看,芯片设计的门槛正在降低。一方面EDA等工具链正在逐渐完善,另一方面,Arm提供的IP内核,也为芯片设计者提供了很多预设。业界专家告诉《中国电子报》记者,当前芯片设计的难度正在逐步降低,相较于五六年之前已经大打折扣。相比造芯,对于芯片的迭代和调优过程,也就是如何让芯片走向能用和好用,才是最考验微软的地方。黄仁勋为何站台?对于很多“蹲”微软发布会的观众来说,英伟达CEO黄仁勋的出现点燃了发布会的一波高潮。自10月微软造芯的消息传出,网络上流传着很多关于“微软们撬动英伟达”的声音。关于微软自研AI芯片是否会抢占英伟达GPU市场的话题,引发了产业界的热议。而黄仁勋此次到微软发布会“捧场”,看似使微软与英伟达进行市场争夺的猜测不攻自破,而他发布的内容,也展示了两家企业在AI业务领域的新谋划。黄仁勋表示,企业使用AI能力主要基于三种模式:一是基于ChatGPT等公有云服务,二是基于Windows等内嵌AI应用的操作系统,三是基于自己的数据和规则定制化创建大模型。而这第三点,正是AI未来的潜力所在。11月7日,OpenAI发布了名为GPT-4 Turbo的新模型,可支持用户实现“自定义模型”,即通过给模型专有数据,使其可以处理个别细分领域的任务。此次发布会上还发布了ChatGPT的自定义版本GPTs,支持用户的定制化需求。微软Ignite大会上,支持定制化AI服务同样是发布重点。当“人人都可训练模型”,未来的增量市场就相当可观。

萨提亚·纳德拉发布Azure Cobalt 100另一方面,现有处理器不是最适合AI的,几乎已经成为算力芯片供应商的共识。这也是在大模型浪潮的推动下,NPU、APU、TPU等AI专用处理器类型纷繁迭出的底层逻辑。在AMD、英特尔等传统处理器企业之外,芯片设计已经吸引了亚马逊、谷歌、腾讯、阿里等云服务商入场。作为服务器芯片最大的客户,以微软为代表的云服务商最了解对芯片的需求。从微软的角度来看,一面是可见的日益走高的处理器购置费用,另一面是选择更适配AI硬件的需求推动。拿出一些成本,给自身业务的硬件配置提供新选择,何乐而不为?而选择做CPU,而不仅仅是做AI加速卡,恐怕也是基于未来增长可能性的考量:在自己已有相当的市场容量的基础上,采用功耗更低的Arm设计CPU,也可以在一定程度上实现风险对冲。那么微软造芯,真得能做得好吗?所谓微软“造芯”,实际上是指入局芯片设计行业。从芯片的全生命周期来看,芯片设计的门槛正在降低。一方面EDA等工具链正在逐渐完善,另一方面,Arm提供的IP内核,也为芯片设计者提供了很多预设。业界专家告诉《中国电子报》记者,当前芯片设计的难度正在逐步降低,相较于五六年之前已经大打折扣。相比造芯,对于芯片的迭代和调优过程,也就是如何让芯片走向能用和好用,才是最考验微软的地方。黄仁勋为何站台?对于很多“蹲”微软发布会的观众来说,英伟达CEO黄仁勋的出现点燃了发布会的一波高潮。自10月微软造芯的消息传出,网络上流传着很多关于“微软们撬动英伟达”的声音。关于微软自研AI芯片是否会抢占英伟达GPU市场的话题,引发了产业界的热议。而黄仁勋此次到微软发布会“捧场”,看似使微软与英伟达进行市场争夺的猜测不攻自破,而他发布的内容,也展示了两家企业在AI业务领域的新谋划。黄仁勋表示,企业使用AI能力主要基于三种模式:一是基于ChatGPT等公有云服务,二是基于Windows等内嵌AI应用的操作系统,三是基于自己的数据和规则定制化创建大模型。而这第三点,正是AI未来的潜力所在。11月7日,OpenAI发布了名为GPT-4 Turbo的新模型,可支持用户实现“自定义模型”,即通过给模型专有数据,使其可以处理个别细分领域的任务。此次发布会上还发布了ChatGPT的自定义版本GPTs,支持用户的定制化需求。微软Ignite大会上,支持定制化AI服务同样是发布重点。当“人人都可训练模型”,未来的增量市场就相当可观。 OpenAI首次开发者大会提出模型客制化接下来黄仁勋的发言,给定制化AI模型提供了一个具象化的实现方式:“我们将成为AI模型的代工厂。”所谓“代工厂”,也就是英伟达基于微软Azure提供的生成式AI Foundry(AI代工)服务,这项服务整合了英伟达的AI基础模型、 NeMo云原生框架和工具以及 NVIDIA DGX云端AI超算服务,面向企业提供创建自定义 AIGC 模型的端到端解决方案,支持企业定制模型以更高效地支持AIGC应用。在Ignite 2023现场,黄仁勋回顾了英伟达与微软团队在过去一年的合作成果。包括双方共同打造的AI超级计算机已经成为全球速度最快的AI超级计算机和全球第三快的超级计算机,以及“英伟达GPU+Windows PC”的合作模式构建了将大模型从云端推广到PC端和工作站的安装基础等。双方还透露除了AI Foundry服务,英伟达还将产业数字化平台Omniverse托管到了Azure,以及英伟达已经获得了微软AI助手Copilot的全站许可。两大科技头部企业CEO同台,针锋相对的意思没看到,倒是看出了很多在AI浪潮推动下“慕强”的味道。AI颠覆一切?就像黄仁勋在发布会现场所说的:“过去四十年,(计算产业)还没有发生过(影响力)如此大的事情(生成式人工智能)。它比PC大,比手机还大,这是计算机行业历史上最大规模的TAM(可触达市场)扩张。”生成式人工智能的出现,给算力市场带来的影响是颠覆性的。在生成式人工智能的推动下,算力的需求急遽攀升,供给出现严重不足。原有软硬件、云服务商等市场参与者之间泾渭分明的界限,也因为算力需求的攀升被打破。在满足算力需求的过程中,各种技术路线正呈现融合趋势。例如CPU和NPU正在从松散的耦合走向异构融合等等。在这样的趋势下,微软与英伟达的持续合作就变得容易理解。在AI上云的初期,微软利用英伟达GPU给Azure的虚拟机加速,英伟达通过微软Azure扩张在云计算的市场。当ChatGPT横空出世,微软与英伟达共同打造AI超级计算机探索AIGC的发展。英伟达还受邀将软件栈托管到Azure,让英伟达CUDA平台的开发者成为微软Azure的客户。本次推出的AI Foundry服务,将使双方在AIGC的合作更加紧密。AI时代,生态为王——微软和英伟达的合作一直基于这个逻辑,从简单的软硬件结合走向了系统软件级别的合作,接下来也将向生态级别升维。在生成式AI的浪潮下,把握机会找准合作对象占领市场最为要紧,芯片供应是否存在变化,也不再是头部厂商最关注的点。可能老黄也会觉得,最终市场归谁所有,时间自会给出答案。

OpenAI首次开发者大会提出模型客制化接下来黄仁勋的发言,给定制化AI模型提供了一个具象化的实现方式:“我们将成为AI模型的代工厂。”所谓“代工厂”,也就是英伟达基于微软Azure提供的生成式AI Foundry(AI代工)服务,这项服务整合了英伟达的AI基础模型、 NeMo云原生框架和工具以及 NVIDIA DGX云端AI超算服务,面向企业提供创建自定义 AIGC 模型的端到端解决方案,支持企业定制模型以更高效地支持AIGC应用。在Ignite 2023现场,黄仁勋回顾了英伟达与微软团队在过去一年的合作成果。包括双方共同打造的AI超级计算机已经成为全球速度最快的AI超级计算机和全球第三快的超级计算机,以及“英伟达GPU+Windows PC”的合作模式构建了将大模型从云端推广到PC端和工作站的安装基础等。双方还透露除了AI Foundry服务,英伟达还将产业数字化平台Omniverse托管到了Azure,以及英伟达已经获得了微软AI助手Copilot的全站许可。两大科技头部企业CEO同台,针锋相对的意思没看到,倒是看出了很多在AI浪潮推动下“慕强”的味道。AI颠覆一切?就像黄仁勋在发布会现场所说的:“过去四十年,(计算产业)还没有发生过(影响力)如此大的事情(生成式人工智能)。它比PC大,比手机还大,这是计算机行业历史上最大规模的TAM(可触达市场)扩张。”生成式人工智能的出现,给算力市场带来的影响是颠覆性的。在生成式人工智能的推动下,算力的需求急遽攀升,供给出现严重不足。原有软硬件、云服务商等市场参与者之间泾渭分明的界限,也因为算力需求的攀升被打破。在满足算力需求的过程中,各种技术路线正呈现融合趋势。例如CPU和NPU正在从松散的耦合走向异构融合等等。在这样的趋势下,微软与英伟达的持续合作就变得容易理解。在AI上云的初期,微软利用英伟达GPU给Azure的虚拟机加速,英伟达通过微软Azure扩张在云计算的市场。当ChatGPT横空出世,微软与英伟达共同打造AI超级计算机探索AIGC的发展。英伟达还受邀将软件栈托管到Azure,让英伟达CUDA平台的开发者成为微软Azure的客户。本次推出的AI Foundry服务,将使双方在AIGC的合作更加紧密。AI时代,生态为王——微软和英伟达的合作一直基于这个逻辑,从简单的软硬件结合走向了系统软件级别的合作,接下来也将向生态级别升维。在生成式AI的浪潮下,把握机会找准合作对象占领市场最为要紧,芯片供应是否存在变化,也不再是头部厂商最关注的点。可能老黄也会觉得,最终市场归谁所有,时间自会给出答案。作者丨姬晓婷 张心怡编辑丨邱江勇美编丨马利亚监制丨连晓东

微软发布自研芯片,英伟达黄仁勋为何站台?解析行业合作动机相关教程

-

英伟达黄仁勋:免费提供对手的GPU芯片,华为不为所动,暗含讽刺?

英伟达黄仁勋:免费提供对手的GPU芯片,华为不为所动,暗含讽刺?2024-03-12

-

黄仁勋最新采访:分享英伟达的崛起历史和未来发展展望

黄仁勋最新采访:分享英伟达的崛起历史和未来发展展望2024-03-11

-

黄仁勋称:即使竞争对手免费提供AI芯片,英伟达方案依旧无可撼动

黄仁勋称:即使竞争对手免费提供AI芯片,英伟达方案依旧无可撼动2024-03-11

-

黄仁勋:英伟达(NVIDIA)对深度学习的发展影响及其重要性

黄仁勋:英伟达(NVIDIA)对深度学习的发展影响及其重要性2024-01-21

- 英伟达/AMD/英特尔的哪些芯片将受限?- 热门芯片限制分析

- 独家英伟达股价十连涨创新高,但黄仁勋高兴不起来

- AMD发布全新AI芯片与英伟达对决

- 突发!英伟达高性能AI芯片被禁,国产算力迎来春天

- AMD挑战英伟达的“软件统治”,收购初创公司以AMD芯片做AI

- 英伟达宣布与日立集团合作,企业级大模型或成下一个风口?

- AMD处理器继续蚕食Intel!服务器收入份额已达33%——AMD处理器在服务器市场占有率持续攀升!

- 微软自研5000亿参数武器曝光,前谷歌DeepMind高管挑战OpenAI!

- 苹果或在今晚发布Apple Pencil Pro,雷军逛完北京车展后感到绝望

- 辉煌的NVIDIA AIC厂商,但有着不同的命运:探索不同的市场发展之路

- 微软疯狂押注AI,焦虑和野心再也藏不住

- 微软披露安卓“脏流”漏洞,小米和WPS Office上榜修复情况

系统资讯推荐

- 1 微软自研5000亿参数武器曝光,前谷歌DeepMind高管挑战OpenAI!

- 2 苹果或在今晚发布Apple Pencil Pro,雷军逛完北京车展后感到绝望

- 3 微软疯狂押注AI,焦虑和野心再也藏不住

- 4 次时代显卡的小秘密 这个选项你打开了吗?揭秘最新显卡的黑科技

- 5 Windows 11强制全屏弹窗?力推Edge等应用,用户体验受影响

- 6 下一代Windows要大变革:“真AI PC”要来了,革命性的人工智能电脑即将问世

- 7 NVIDIA ChatRTX聊天机器人支持Google Gemma模型和语音查询功能

- 8 如何修改电脑WIN10、WIN11系统excel、word底色?

- 9 骁龙8gen3 CPU性能接近10代i5 10400?极客湾测评揭晓答案

- 10 大白话告诉你显卡参数都是啥意思,显卡参数解析及选择技巧

win10系统推荐